工欲善其事,必先利其器

个人成长思考

认真对待工作生活中每一件事

核心能力:

- 技术(学思练写)

- 英语(听说读写)

- 写作

- 沟通

- 刷题

技术

技术是工具,掌握学习新技术,以及使用新技术的方法更重要,当然深厚的计算机基础以及广泛的涉猎是必须的

如何学好技术

博观而约取,厚积而薄发

保持好奇心

- 对于自己不会的点,查缺补漏,要弄通透,不能只当时查了用,等闲下来还是要再研究研究

不求甚解

- 对于一时看不懂的点,先看个大概,心底有个印象,多练多用,等过段时间再遇到,说不定就能看懂了

保持学习

- 抽空多看技术博客,加深积累

保持思考

- 多倾听别人的想法,思考其中是否有可取之处,但是也要保持批判精神,不能盲信

记录心得

- 阅读以及听课,知识留存率都比较低,而思考过后,把听到的知识转化为心得输出,能掌握的更为透彻

保持练习

- 刷题,多写代码

数据结构与算法知识点整理

C++服务器开发学习路线

TCP/IP协议栈学习笔记

深度学习笔记

环境准备

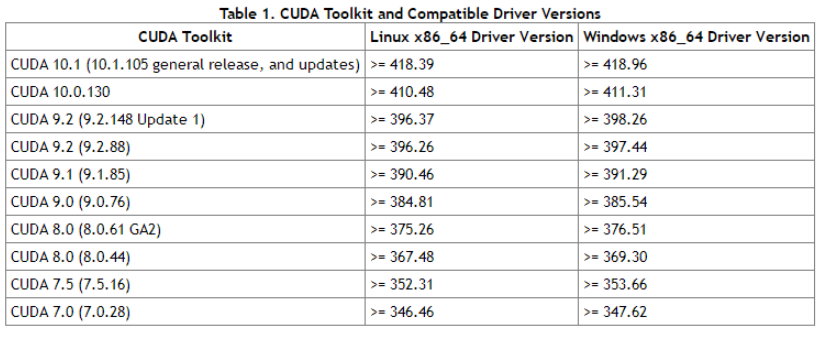

Cuda对应图

用Conda安装指定Cuda版本的Pytorch

1 | conda install pytorch cudatoolkit=10.1 -c pytorch |

安装多版本Cuda(用Pytorch框架不用安装Cuda)

下载安装

1 | # 根据Cuda对应图下载指定版本的cuda,下载runfile文件,这里以10.1为例 |

使用软链接更方便切换版本

1 | # 先将/usr/bin/cuda软链接指向指定版本 |

每次切换版本只需要重建软链接就可以了。

训练技巧

模型参数初始化

普通梯度下降法(SGD,Batch梯度下降)

使用普通的梯度下降方法时,初始化模型时对参数进行归一化,以防止不同参数的scale不一样,部分参数在同等学习率下无法更新

自适应学习率梯度下降法法(动量法,RMSprop算法,Adam算法)

采用自适应学习率的梯度下降方法不需要对参数进行归一化,因为会根据不同scale的梯度进行学习率的缩放,最终稳步达到lLocal optimal

梯度下降优化方法

jupyter-notebook使用笔记

jupyter-notebook使用配置

使用pip进行安装

1 | pip install jupyter |

生成配置文件

1 | jupyter-notebook --generate-config |

生成密码

1 | jupyter-notebook password # 输入密码后会生成到一个json文件,等下复制到~/.jupyter/jupyter_notebook_config.py |

配置~/.jupyter/jupyter_notebook_config.py

1 |

|

Linux使用笔记

Linux常用操作

创建sudo和ssh用户

创建用户并设置sudo权限

1 | # 使用adduer添加用户会在home目录中添加用户,并设置shell环境(/bin/bash),而useradd不会 |